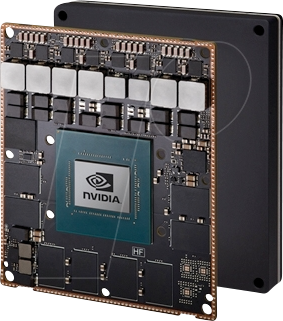

Nvidia Grafik-Prozessor / GPU Nvidia H200 Tensor Core 141 GB HBM3e-RAM PCIe x16 PCIe 5.0 x16, PCIe 4.0 x16

Die Grafikkarte für generative KI und HPC Die NVIDIA H200-Tensor-Core-Grafikkarte bietet generative KI- und HPC(High-Performa... Mehr erfahren

Finde die besten Angebote

Bester Preis15072 Punkte

Conrad

Versandkostenfrei

Lieferzeit: 2-3 Werktage

Versandkostenfrei | Lieferzeit: 2-3 Werktage

Ähnliche Produkte

Produktdetails

Die Grafikkarte für generative KI und HPC Die NVIDIA H200-Tensor-Core-Grafikkarte bietet generative KI- und HPC(High-Performance Computing)-Workloads mit bahnbrechender Leistung und Speicherkapazität. Als erste Grafikkarte mit HBM3e treibt der größere und schnellere Speicher der H200 die Beschleunigung generativer KI und großer Sprachmodelle (LLMs) an und beschleunigt gleichzeitig wissenschaftliche Berechnungen für HPC-Workloads. Höhere Leistung mit größerem und schnellerem Speicher Die NVIDIA H200 basiert auf der NVIDIA Hopper™- Architektur und ist die erste Grafikkarte mit 141 Gigabyte (GB) HBM3e-Speicher bei einer Leistung von 4,8 Terabyte pro Sekunde (TB/s) – das entspricht fast der doppelten Kapazität der NVIDIA H100 Tensor Core-Grafikkarte mit 1,4-facher Speicherbandbreite. Der größere und schnellere Speicher der H200 beschleunigt generative KI und LLMs und bringt gleichzeitig das wissenschaftliche Computing für HPC-Workloads mit besserer Energieeffizienz und niedrigeren Gesamtbetriebskosten voran. Erkenntnisse mit hochleistungsfähiger LLM-Inferenz gewinnen In der sich ständig weiterentwickelnden KI-Landschaft verlassen sich Unternehmen auf LLMs, um eine Vielzahl von Inferenzanforderungen zu erfüllen. Ein KI-Inferenzbeschleuniger muss den höchsten Durchsatz bei geringstmöglichen Gesamtbetriebskosten bieten, wenn er für eine riesige Nutzerbasis im großen Umfang bereitgestellt wird. Die H200 verdoppelt die Inferenzgeschwindigkeit bei der Verarbeitung von LLMs wie Llama2 im Vergleich zu H100-Grafikprozessoren. High-Performance Computing mit Superturbo Die Speicherbandbreite ist für HPC-Anwendungen von entscheidender Bedeutung, da sie eine schnellere Datenübertragung ermöglicht und Engpässe bei der komplexen Verarbeitung reduziert. Für speicherintensive HPC-Anwendungen wie Simulationen, Forschung und künstliche Intelligenz stellt die höhere Speicherbandbreite von H200 sicher, dass Daten effizient abgerufen und bearbeitet werden können, was bis zu einer 110-mal schnelleren Ergebnisbereitstellung im Vergleich zu CPUs führt. Reduzierung des Energieverbrauchs und der Gesamtbetriebskosten Mit der Einführung der H200 erreichen Energieeffizienz und Gesamtbetriebskosten ein neues Niveau. Diese bahnbrechende Technologie bietet unvergleichliche Leistung innerhalb desselben Leistungsprofils wie die H100. KI-Werke und Supercomputing-Systeme, die nicht nur schneller, sondern auch umweltfreundlicher sind, bieten einen wirtschaftlichen Vorteil, der die KI- und Wissenschaftswelt voranbringt. KI-Beschleunigung für Mainstream-Enterprise-Server Die NVIDIA H200 NVL ist ideal für Unternehmen mit luftgekühlten Rack-Systemen geringerer Leistung, die flexible Konfigurationen erfordern, und beschleunigt KI- und HPC-Workloads unabhängig von ihrer Größe. Mit bis zu vier über NVIDIA NVLink™ verbundenen GPUs und einer 1,5-fachen Speichererweiterung kann die Inferenz mit großen Sprachmodellen (LLM) bis zu 1,7-fach beschleunigt werden und erreichen HPC-Anwendungen eine bis zu 1,3-fache höhere Leistung gegenüber der H100 NVL.

Informationen

Lieferzeit:2-3 Werktage

Marke:NVIDIA